Negli ultimi anni, la tecnologia ha fatto passi da gigante, soprattutto nel campo dell’intelligenza artificiale (IA): una tecnologia che cerca di imitare, attraverso algoritmi sempre più sofisticati, il pensiero e altre abilità umane. Ormai riesce a esprimersi, comunicare e persino produrre ragionamenti.

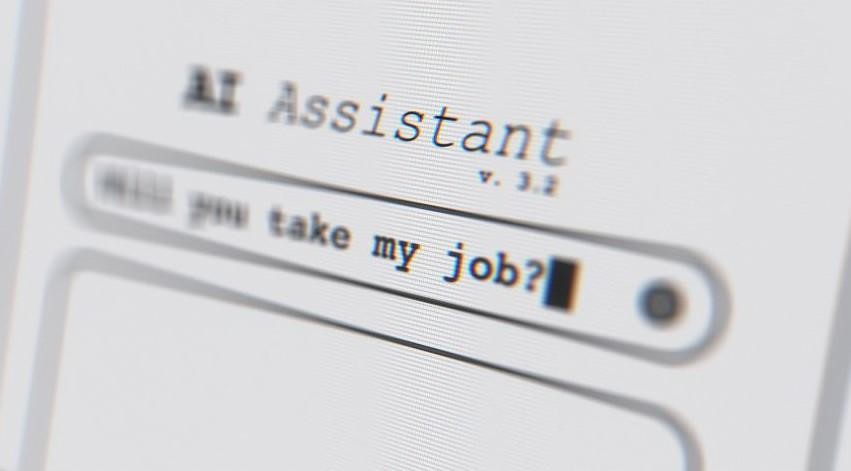

Quindi la domanda sorge spontanea: l’intelligenza artificiale sarà in grado di sostituire gli psicoterapeuti?

È una delle domande centrali nel dibattito su intelligenza artificiale e psicoterapia, e la risposta breve è: no, non completamente. Vediamo insieme perché.

Cosa fa funzionare davvero una terapia?

Per iniziare, dobbiamo capire cosa rende efficace una psicoterapia. Da fuori può sembrare un semplice dialogo tra terapeuta e paziente, in cui il primo ascolta e conforta il secondo.

Se fosse solo questo, l’intelligenza artificiale avrebbe pochi problemi: potrebbe studiare enormi quantità di articoli scientifici e trascrizioni di sedute per restituire risposte simili a quelle di un terapeuta umano. Ma la verità è che il legame terapeutico si basa su meccanismi molto più profondi—e ancora poco conosciuti.

Chatbot e psicoterapia: le origini dell’intelligenza artificiale in psicoterapia

Uno dei primi esperimenti di chatbot in ambito psicoterapeutico è stato Eliza, creata da Joseph Weizenbaum nel 1966. Il software si basava sull’elaborazione del linguaggio naturale e riusciva a sostenere un primo colloquio terapeutico, assumendo un ruolo simile a quello dello psicoterapeuta.

Weizenbaum, però, voleva proprio dimostrare i limiti dell’IA nel sostituire un essere umano. Eppure, molti utenti attribuivano a Eliza caratteristiche umane, come l’empatia. Probabilmente perché pensavano: “se risponde al mio dolore, allora mi capisce”.

Un esempio per capire meglio

Immagina di voler parlare con qualcuno che conosce solo un dialetto remoto della Mongolia. Tu non parli quella lingua, ma hai accesso a tanti esempi di conversazioni: impari che a certe combinazioni di parole corrispondono certe risposte.

Così puoi “parlare” senza capire davvero: individui parole chiave, ripeti frasi come domande e la conversazione procede. È esattamente ciò che faceva Eliza.

Conversazione psicoterapeutica o illusione? IA e psicoterapia a confronto

Anni dopo, uno studio esplorativo (Cristea et al., 2013) ha confrontato Eliza con un terapeuta umano in una sessione con pazienti. Lo scopo era analizzare elementi comuni e differenze nei dialoghi, valutati poi da alcuni professionisti tramite sondaggio.

Eliza utilizzava schemi di riconoscimento e riformulazione delle parole chiave, mentre il terapeuta umano interveniva direttamente con strumenti della terapia cognitivo-comportamentale.

I risultati? Molti valutatori ritenevano entrambi i “terapeuti” umani, anche se con stili diversi. La vera differenza emersa riguardava la qualità della relazione terapeutica, in particolare aspetti come empatia e interesse verso il paziente.

Non è solo questione di parole

Nel 2022, uno studio di Sedlakova & Trachsel ha sottolineato che, sebbene l’IA possa simulare una risposta empatica, l’esperienza umana condivisa non è replicabile da un algoritmo.

Le persone che cercano aiuto psicologico sono spesso in uno stato di fragilità: l’intelligenza artificiale può solo creare l’illusione di una relazione. Ma chi sceglierebbe una relazione illusoria con il proprio terapeuta?

I rischi dell’intelligenza artificiale in psicoterapia

Nel 2020, Horn & Weisz hanno evidenziato diversi rischi legati all’uso dell’IA in psicoterapia, soprattutto con la crescente popolarità dei modelli linguistici avanzati (LLM), come ChatGPT.

Uno dei pericoli è lo sviluppo di interventi terapeutici che potrebbero risultare inefficaci o persino dannosi per i pazienti. Per questo è essenziale usare questi strumenti con consapevolezza, trasparenza e chiarezza nei confronti di chi chiede aiuto.

L’intelligenza artificiale come alleata nella psicoterapia

Come abbiamo detto all’inizio, l’intelligenza artificiale non può sostituire lo psicoterapeuta. Ma può affiancarlo e potenziare il suo lavoro.

Fuori dalla seduta, l’IA può essere utile per:

-

scrivere materiali informativi per i pazienti;

-

supportare i professionisti nella creazione di contenuti o nella gestione dei social;

-

sviluppare strumenti interattivi per migliorare l’efficacia del percorso terapeutico.

Chi saprà usare bene questi strumenti, potrà lavorare con più creatività, impatto e precisione. L’unione tra intelligenza artificiale e psicoterapia può portare a nuove forme di supporto, se guidata da consapevolezza clinica.

Psicoterapia personalizzata: il contributo dell’intelligenza artificiale

Uno dei principali vantaggi dell’IA è la possibilità di personalizzare i trattamenti. Ogni persona è unica e può rispondere in modo diverso alla stessa terapia.

L’intelligenza artificiale può individuare caratteristiche specifiche dei pazienti (linguaggio, tono di voce, segnali fisiologici) e suggerire strategie personalizzate. Inoltre, permette un monitoraggio più preciso dei progressi e l’adattamento della terapia.

Sta emergendo anche il campo del digital phenotyping: una nuova frontiera che usa dispositivi quotidiani (come smartphone o wearable) per monitorare il benessere psicologico in tempo reale.

Può l’IA sostituire davvero lo psicoterapeuta?

Nonostante i progressi, l’IA non può replicare l’empatia, l’intuito e la presenza autentica di un terapeuta. Alcuni chatbot offrono supporto iniziale in caso di ansia o depressione, ma rimangono strumenti complementari.

Ricordiamoci: la relazione è il cuore della terapia. Un terapeuta non si limita a interpretare sintomi, ma accoglie, comprende e adatta l’approccio alle emozioni e alla storia della persona.

L’uso della sola tecnologia rischia di semplificare troppo, portando a diagnosi approssimative, sfiducia e peggioramento del quadro clinico.

L’IA può:

-

aiutare a monitorare il benessere emotivo;

-

proporre esercizi di mindfulness;

-

offrire un primo orientamento verso un percorso terapeutico.

Ma non può:

-

provare empatia autentica;

-

leggere il linguaggio del corpo o le micro-espressioni;

-

sintonizzarsi sul ritmo emotivo di una relazione.

Conclusione: intelligenza artificiale e psicoterapia possono convivere?

Intelligenza artificiale e psicoterapia non sono nemiche. Al contrario, l’IA rappresenta una grande opportunità per il mondo della salute mentale, offrendo nuovi strumenti per migliorare diagnosi e trattamenti.

Tuttavia, la tecnologia non può sostituire la connessione umana, l’ascolto profondo e l’empatia che rendono efficace un percorso terapeutico.

L’intelligenza artificiale va vista come un alleato etico e consapevole, capace di arricchire il lavoro dello psicoterapeuta, senza mai perdere di vista ciò che rende la terapia davvero trasformativa: la relazione.

Gabriele Nobile

Rebecca Montresor